LLM ‘Solar’ 공개, 발표와 함께 ‘허깅페이스 오픈 LLM 리더보드’에서 세계 1위

세계 최초 10.7B 매개변수로 구성된 소형 모델로 글로벌 톱 생성 AI 모델 등극

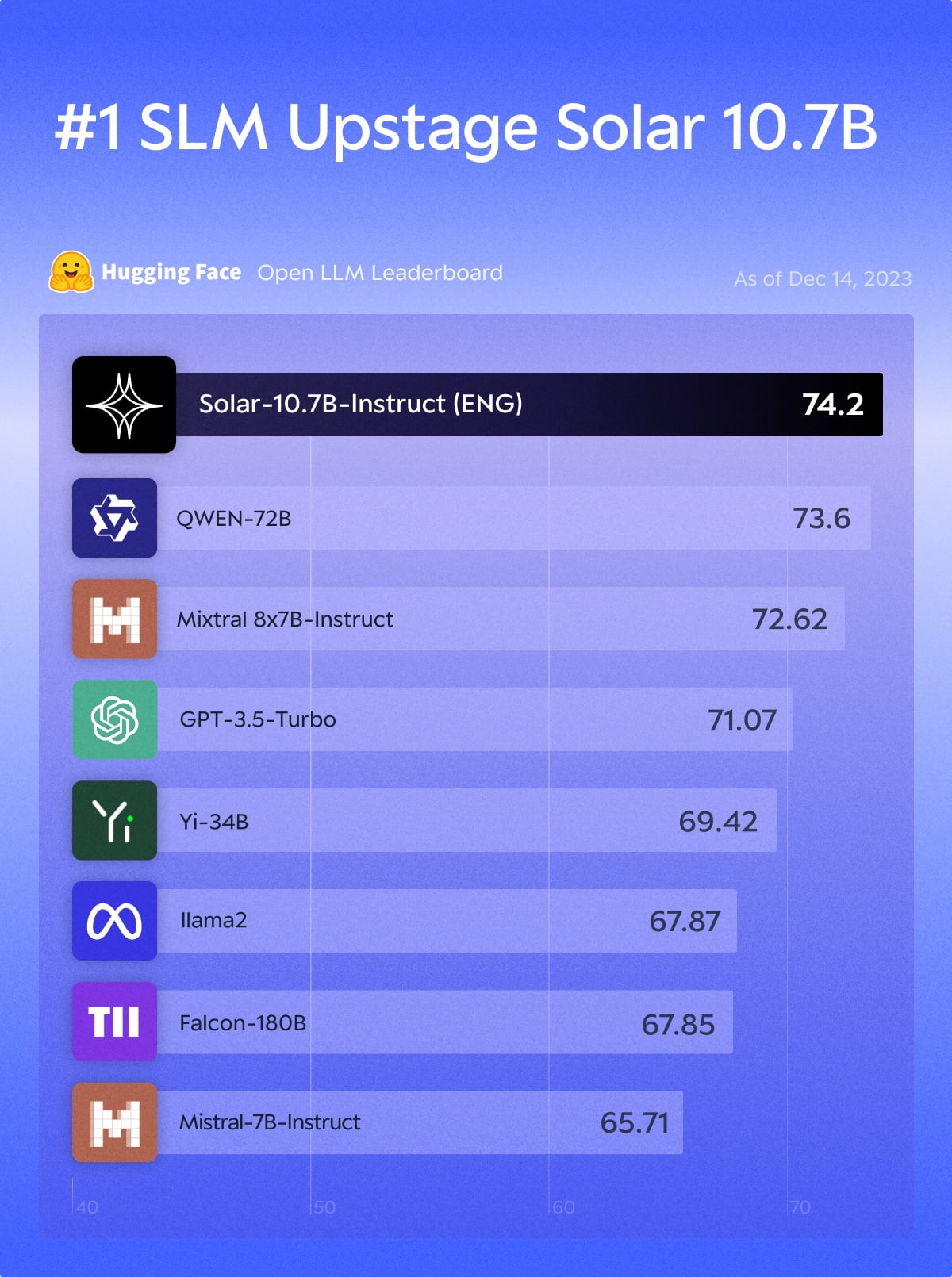

14일 업스테이지는 세계 최대 머신러닝 플랫폼 허깅페이스에서 운영하는 ‘오픈 LLM 리더보드’에서 세계 1위를 차지한 사전학습 LLM 솔라를 공개했다고 밝혔다. 이번 결과는 소형 LLM(SLM)의 기준이라고 할 수 있는 300억 매개변수(30B) 이하 사이즈로 글로벌 최고 성능 모델에 올라 더욱 의미가 깊다.

업스테이지 솔라는 ‘Specialized and Optimized Llm and Applications with Reliability’의 약자로, 업스테이지는 지난 8월, 오픈LLM 역사상 최초로 GPT-3.5의 벤치마크 점수를 뛰어넘어 주목을 받은 자사의 허깅페이스 1위 모델을 시작으로 솔라 모델을 개발했다.

허깅페이스 오픈 LLM 리더보드는 오픈소스 생성 AI 모델의 바로미터로 꼽힌다. 전 세계 500여개의 오픈 모델들이 추론과 상식 능력, 언어 이해 종합능력 및 환각현상(할루시네이션) 방지, 대명사 참조 및 수학 해결 능력 등 6가지 지표의 평균 점수로 경쟁, 공신력 있는 순위가 매겨진다.

업스테이지의 ‘솔라’는 기업들이 활용하기 좋은 프라이빗 LLM을 위해 작은 크기로 구성된 사전학습 모델로, 세계 최초의 107억 매개변수(10.7B) 모델이다. 업스테이지는 고도의 지능과 컴팩트함이라는 완벽한 균형을 찾은 모델이라고 평가했다. 업스테이지 솔라는 리더보드 평가에서 74.2점을 기록하며 전체 1위를 차지하는 기염을 토했다. 이로서 업스테이지의 솔라는 알리바바의 최신 모델인 큐원(Qwen)의 6분의 1도 안되는 크기로 이를 훌쩍 뛰어넘는 성능을 증명했다.

업스테이지는 다양한 연구를 통해 작은 사이즈의 솔라 모델 성능을 최적화했다. 업스테이지는 성능이 좋지만 큰 13B 모델과 충분히 작지만 지적 제약이 있는 7B 모델 사이의 장점을 모두 잡는 최적의 모델 크기를 찾기 위해 오픈소스의 7B 모델들을 기반으로 자체적인Depth Up-Scaling 방식을 적용, 레이어를 추가하며 깊이를 더해 소형 모델의 성능을 극대화했다. 그 결과 업스테이지는 3조 개가 넘는 토큰의 우수한 데이터를 통해 확장된 10.7B를 완성, 크기와 성능의 최적의 조합으로 모델을 구축했다고 밝혔다.

또한, 업스테이지의 솔라 모델은 사전 학습 및 파인튜닝 단계에서는 리더보드 벤치마킹 데이터 셋을 사용하지 않고, 자체적으로 구축한 데이터를 적용했다. 이는 리더보드 점수를 높이기 위해 벤치마크 셋을 직접 적용하는 모델들의 사례와 달리 솔라는 다양한 태스크의 실제 업무 활용 등 일반적인 경우 높은 사용성을 보여줄 수 있음을 반증한다.

특히 최근 20억 달러의 기업 가치로 유니콘에 오른 미스트랄AI의 최신 모델 믹스트랄(Mixtral 8x7B) 모델의 성능지표마저 뛰어넘어 글로벌 무대의 이목도 집중시켰다. 믹스트랄은 작은 전문 모델 여러 개를 묶는 방식으로 소형 모델임에도 메타 ‘라마’와 GPT-3.5를 능가해 최근 가장 뜨거운 관심을 받고 있는 모델이다. 믹스트랄은 70억 파라미터의 전문 모델 8개를 묶어 사전학습 모델 중 최고의 성능을 보인 바 있지만, 업스테이지의 솔라는 고도의 모델링 노하우와 최적화 기술력으로 믹스트랄 모델보다 더 가벼운 크기에도 불구하고, 벤치마크평가에서 더 나은 성능을 보였다.

업스테이지의 김성훈 대표는 “세계 AI회사들을 압도하는 모델을 공개하게 되어 기쁘고 업스테이지 솔라가 모두를 위한 모델이 되기를 희망한다” 며 “KT의 전략투자를 통한 지원이 큰 도움이 되었고 앞으로 지속적으로 더 큰 격차를 벌릴 수 있는 최고 성능의 솔라 모델을 활용, B2B 시장에서의 협력도 추진할 것”이라고 밝혔다.

최수진 기자 jinny0618@hankyung.com

© 매거진한경, 무단전재 및 재배포 금지