18일(현지시각)로이터에 따르면, 엔비디아는 이날 미국 캘리포니아주 새너제이 SAP 센터에서 개발자 콘퍼런스 'GTC(GPU Technology Conference) 2024'를 열고 새로운 그래픽처리장치(GPU) '블랙웰'을 기반으로 한 차세대 AI칩 'B100'을 발표했다.

또한 개발자가 AI 모델을 더 쉽게 쓸 수 있도록 하는 새로운 소프트웨어 도구에 대해서도 자세히 설명했다.로이터는 GTC 2024에서 발표된 칩과 소프트웨어가 엔비디아가 AI칩 시장에서 점유율 80%를 유지할 수 있을지 여부를 결정하는 데 큰 역할을 할 거라 내다봤다.

엔비디아는 'GB200 NVL72'라는 컴퓨팅 유닛도 공개했다. 블랙웰 GPU 72개와 5세대 NV링크로 상호 연결한 36개의 그레이스 블랙웰 슈퍼칩과 36개의 그레이스 중앙처리장치(CPU)가 결합한 형태다. GB200 NVL72는 기존 GB200보다 종합 성능이 30배 높은 것으로 알려졌다.

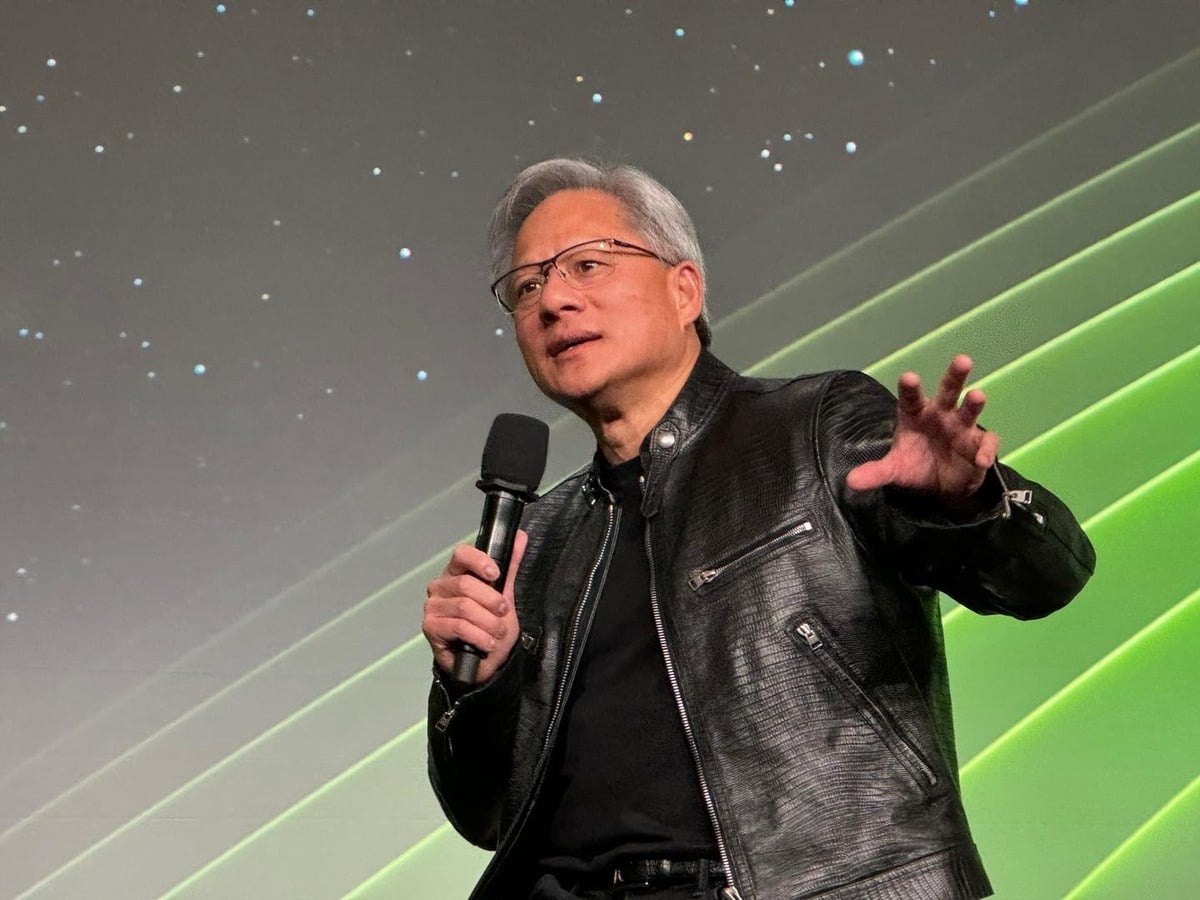

젠슨 황 엔비디아 CEO는 "B200 블랙웰 칩이 챗봇의 답변을 제공하는 것과 같은 작업에서 30배 더 빠르다"고 말했다. 이어 "엔비디아가 지난 30년 동안 딥 러닝, AI와 같은 혁신을 실현하기 위해 가속 컴퓨팅을 추구해 왔다"며 "생성형 AI는 우리 시대를 정의하는 기술로 블랙웰 GPU는 이 새로운 산업 혁명을 구동하는 엔진"이라고 강조했다.

인사이더 인텔리전스의 제이슨 본 분석가는 "AMD, 인텔, 스타트업, 심지어 빅테크의 자체 칩 개발까지 경쟁자들이 특히 비용에 민감한 기업 고객 사이에서 엔비디아의 시장 점유율을 위협하고 있다"고 말했다.

엔비디아는 하드웨어 제품으로 널리 알려졌지만, 소프트웨어 도구인 '쿠다'도 개발해 왔다. 쿠다는 개발자가 엔비디아의 GPU를 사용해 고성능 컴퓨팅(HPC), 기계학습, 딥러닝, 그래픽 처리 등 다양한 분야에서 GPU의 강력한 계산 능력을 활용할 수 있게 만들어주는 소프트웨어 도구다.

행사 이튿날 젠슨 황 CEO는 삼성전자 고대역폭 메모리(HBM)에 대해서도 언급했다.

황 CEO는 '삼성의 HBM을 사용하고 있나'라는 질문에 "아직 사용하고 있지 않다"면서도 "현재 테스트하고(qualifying) 있으며 기대가 크다"고 언급했다.

HBM은 D램 여러 개를 수직으로 연결해 데이터 처리 속도를 크게 높인 제품이다. 방대한 데이터를 신속하고 끊임없이 처리해야 하는 생성형 AI를 구동하려면 HBM과 같은 고성능 메모리가 반드시 필요한 것으로 알려져 있다.

HBM은 1세대(HBM)-2세대(HBM2)-3세대(HBM2E)-4세대(HBM3)-5세대(HBM3E) 순으로 개발되고 있으며, HBM3E는 HBM3의 확장 버전이다.

HBM3 시장의 90% 이상을 점유하고 있는 SK하이닉스는 메모리 업체 중 가장 먼저 5세대인 HBM3E D램을 엔비디아에 납품한다고 밝힌 바 있다.

그는 "HBM은 매우 복잡하고 어려운 기술이며, ‘기술적인 기적’과도 같다"면서 이런 기술을 구축하고 있는 삼성과 SK하이닉스를 추켜세우기도 했다.

강홍민 기자 khm@hankyung.com

© 매거진한경, 무단전재 및 재배포 금지